AI-2027: Un vistazo al futuro posible de la superinteligencia artificial

Cambiar el foco: de crecer a resistir (la historia de Foxize)

Shadow AI: El desafío invisible de la IA en las empresas

Foto de Stefano Pollio en Unsplash

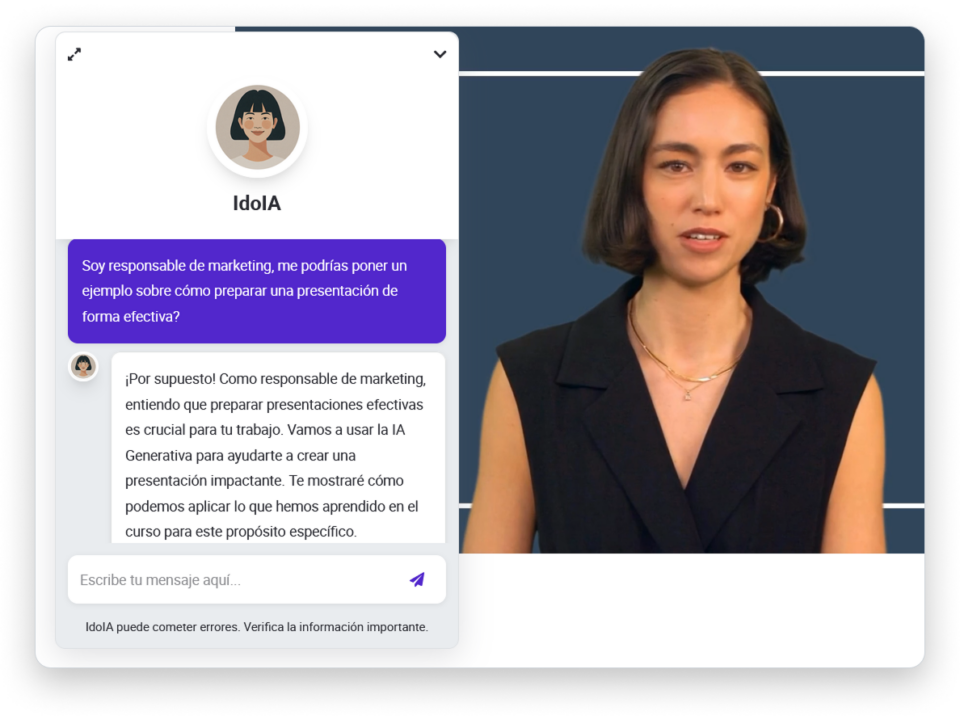

Una escena que todos reconocemos

Marta, analista de marketing en una mediana empresa de moda, llega tarde a la oficina: hoy toca presentar al director un informe con cinco meses de datos de ventas cruzados con tendencias en TikTok. Está a punto de entrar en pánico cuando recuerda aquel chatbot que un amigo le mostró en una cena. Copia‑pega los datos de la hoja de cálculo, añade un prompt rápido («resume las correlaciones y hazme un gráfico») y, ¡voilà!, en menos de dos minutos tiene un análisis pulido listo para copiar en la presentación. Marta brilla en la reunión… hasta que, dos semanas después, un proveedor recibe por error un correo con precios confidenciales. ¿Cómo ha llegado esa información al exterior? Nadie lo sabe todavía, pero la pista empieza en aquel prompt inocente. Bienvenidos a la Shadow AI.

Shadow AI: El desafío invisible de la IA en las empresas

La inteligencia artificial (IA) está remodelando el mundo empresarial a una velocidad sin precedentes. Sin embargo, este avance acelerado no siempre es gestionado de forma centralizada y controlada dentro de las organizaciones. El fenómeno conocido como Shadow AI —o inteligencia artificial en la sombra— está emergiendo como uno de los mayores retos para la gestión tecnológica, la seguridad y la cultura corporativa. Este fenómeno, que consiste en el uso de herramientas de IA generativa por parte de empleados sin el conocimiento ni la aprobación del área de tecnología, está generando tanto oportunidades como riesgos de gran calado.

¿Qué es el Shadow AI y por qué está creciendo?

El concepto de Shadow AI se refiere al uso no autorizado o no supervisado de herramientas de inteligencia artificial dentro de una empresa. A menudo, los empleados recurren a aplicaciones de IA generativa —como asistentes de texto, plataformas de análisis de datos o generadores de imágenes— para mejorar su productividad, automatizar tareas o resolver problemas cotidianos de manera más eficiente. Sin embargo, lo hacen sin la aprobación o el conocimiento explícito del departamento de IT, replicando así el fenómeno de la “shadow IT” de la década pasada, pero con implicaciones mucho más profundas y complejas.

En el artículo Shadow AI: cuando tus empleados van por delante (y tú no te enteras) de Enrique Dans, se explica que este fenómeno es una consecuencia directa de la democratización de la IA generativa. Actualmente existen más de 50.000 herramientas de IA disponibles en el mercado, y cada mes aparecen unas 1.000 nuevas. Estas aplicaciones prometen automatizar más de 16.000 tareas laborales, y su facilidad de acceso hace que los empleados las adopten rápidamente, muchas veces sin esperar la validación oficial de sus organizaciones.

La magnitud del fenómeno queda reflejada en el informe More Than 50% of Workers Admit to Using Unapproved Gen AI Tools” de Futurum Group, que revela que el 55% de los trabajadores han utilizado herramientas de IA generativa no aprobadas en su trabajo, y el 40% incluso ha recurrido a aplicaciones explícitamente prohibidas por la empresa. Este comportamiento refleja la presión por ser más productivos y la percepción de que las políticas internas no avanzan al ritmo de la innovación tecnológica.

Beneficios y riesgos: la doble cara del Shadow AI

El Shadow AI es un arma de doble filo. Por un lado, permite a los empleados ser más eficientes, creativos e innovadores. Por otro, introduce riesgos significativos en materia de seguridad, privacidad y cumplimiento normativo.

Beneficios potenciales

Las herramientas de IA generativa pueden transformar la productividad individual y colectiva. Permiten automatizar tareas repetitivas, generar informes, analizar grandes volúmenes de datos, crear contenidos y asistir en la toma de decisiones. Como señala Dans, la capacidad de resumir documentos extensos, generar reportes o analizar datos complejos en segundos representa una ventaja competitiva indiscutible. Además, el Shadow AI puede ser un indicador de la proactividad y el deseo de innovación de los empleados, que buscan constantemente nuevas formas de optimizar su trabajo.

Riesgos y amenazas

Sin embargo, el uso no controlado de estas herramientas puede comprometer la seguridad de la información y la integridad de los sistemas corporativos. El artículo Shadow AI: Un desafío silencioso para las empresas modernas de Huenei, detalla cómo el Shadow AI puede exponer datos sensibles, crear vulnerabilidades y generar conflictos con los marcos regulatorios.

Fugas de información y privacidad

Uno de los riesgos más graves es la filtración de información confidencial. Cuando los empleados introducen datos sensibles en aplicaciones de IA públicas, pierden el control sobre su almacenamiento y uso. El caso de Samsung, relatado en Lessons learned from ChatGPT’s Samsung leak de Cybernews, es paradigmático: empleados filtraron información estratégica a los servidores de OpenAI al utilizar ChatGPT sin autorización. Este incidente demostró que incluso las empresas más avanzadas pueden ser vulnerables si no gestionan adecuadamente el Shadow AI.

Según Huenei, el 6% de los empleados han copiado y pegado información sensible en herramientas de IA, y un 4% lo hace semanalmente. Esta práctica puede tener consecuencias legales y reputacionales graves, especialmente en sectores regulados.

Cumplimiento normativo y regulación

El Shadow AI puede llevar a incumplimientos regulatorios significativos. En Europa, el Reglamento General de Protección de Datos (RGPD) y la nueva EU AI Act exigen una gestión proactiva de los riesgos asociados a la IA. El artículo Supporting Compliance with the EU AI Act and EU Digital Operational Resilience Act (DORA) for Shadow AI Governance with the Hyperproof GRC Platform de YourDataConnect explica que alimentar datos en plataformas públicas sin control puede provocar sanciones y complicaciones legales, ya que la organización pierde la trazabilidad sobre el tratamiento de la información.

Vulnerabilidades de seguridad y ciberataques

Las herramientas de IA de terceros pueden carecer de los estándares de seguridad de los sistemas internos de la empresa. El artículo What is Shadow AI? The Hidden Risks and Challenges in Modern Organizations de freeCodeCamp señala que estas aplicaciones pueden ser explotadas por actores maliciosos para acceder a la red corporativa, o bien utilizar la información enviada para perfeccionar ataques de ingeniería social. Además, la falta de supervisión puede llevar a que empleados utilicen credenciales corporativas en servicios no autorizados, ampliando la superficie de ataque.

Sesgos y resultados erróneos

Sin una gobernanza adecuada, los modelos de IA pueden generar resultados sesgados, incompletos o erróneos. FreeCodeCamp advierte que la falta de alineación entre los resultados generados por herramientas no oficiales y los sistemas internos puede ocasionar errores costosos y retrasos en la toma de decisiones.

Estrategias para gestionar el Shadow AI

Frente a este panorama, las empresas deben adoptar un enfoque proactivo para gestionar el Shadow AI, equilibrando la innovación con la protección de sus activos más valiosos.

Educación y formación

Intentar frenar el avance de la IA generativa con prohibiciones es inútil. La clave está en la educación y la formación de los empleados. Capacitar al personal en el uso responsable de la IA, la ética tecnológica y la protección de datos es esencial para mitigar los riesgos y aprovechar los beneficios de estas herramientas.

Huenei coincide en la importancia de la formación, sugiriendo que la capacitación en ética de la IA y liderazgo inclusivo puede convertirse en una ventaja competitiva. Los empleados deben entender qué tipo de información pueden compartir y cómo utilizar las herramientas de manera segura.

Políticas y gobernanza clara

Las organizaciones deben desarrollar políticas claras y flexibles que guíen el uso de la IA generativa. YourDataConnect recomienda establecer marcos de gobernanza que aborden los riesgos emergentes y se adapten a la rápida evolución tecnológica. Estas políticas deben definir qué herramientas están permitidas, cómo se deben gestionar los datos y cuáles son las consecuencias de incumplir las normas.

Controles de seguridad y soluciones tecnológicas

Implementar controles de seguridad es fundamental. Huenei sugiere medidas como restringir el uso de aplicaciones no autorizadas, evitar compartir información confidencial en plataformas públicas y no utilizar credenciales corporativas en servicios de IA ajenos a la empresa. Además, algunas organizaciones están adoptando portales intermedios o proxies que permiten acceder a herramientas de IA a través de APIs controladas, desactivando el uso de los datos en el entrenamiento de los modelos, como explica Dans en su artículo.

Supervisión y monitoreo

El monitoreo constante del uso de IA dentro de la organización es vital para detectar comportamientos de Shadow AI y prevenir incidentes. El artículo de freeCodeCamp destaca la importancia de herramientas de auditoría y monitoreo que permitan identificar aplicaciones no autorizadas y evaluar los riesgos asociados.

El Shadow AI como oportunidad

A pesar de los riesgos, el Shadow AI también puede ser una señal de innovación y creatividad dentro de la empresa. El propio Lucas Llarul, Infrastructure & Technology Head en Huenei, afirma que el Shadow AI “es una amenaza que puede convertirse en una oportunidad si se maneja estratégicamente”. La encuesta de Salesforce citada por Futurum Group muestra que el 52% de los empleados incrementó su uso de IA generativa tras adoptarla, lo que sugiere una fuerte demanda de estas herramientas.

Las organizaciones que logren canalizar este impulso innovador, dotando a sus empleados de las herramientas y la formación adecuadas, estarán mejor posicionadas para competir en un entorno donde la IA será cada vez más omnipresente.

Conclusión: hacia una integración responsable de la IA

La inteligencia artificial generativa ha llegado para quedarse, y su adopción por parte de los empleados es una realidad que las empresas no pueden ignorar. El éxito en la gestión del Shadow AI no depende de cuán restrictivas sean las políticas, sino de cuán bien se prepare a los empleados para utilizar estas herramientas de manera responsable y efectiva. La clave está en transformar esta amenaza silenciosa en una ventaja competitiva, implementando estrategias que permitan aprovechar el potencial de la IA mientras se protegen los datos y la reputación de la empresa.